Montag, 26. Mai 2025

Forschungs-KI AMIE wird multimodal: KI-gestützte Diagnostik mit Text, Bildern und klinischem Dialog

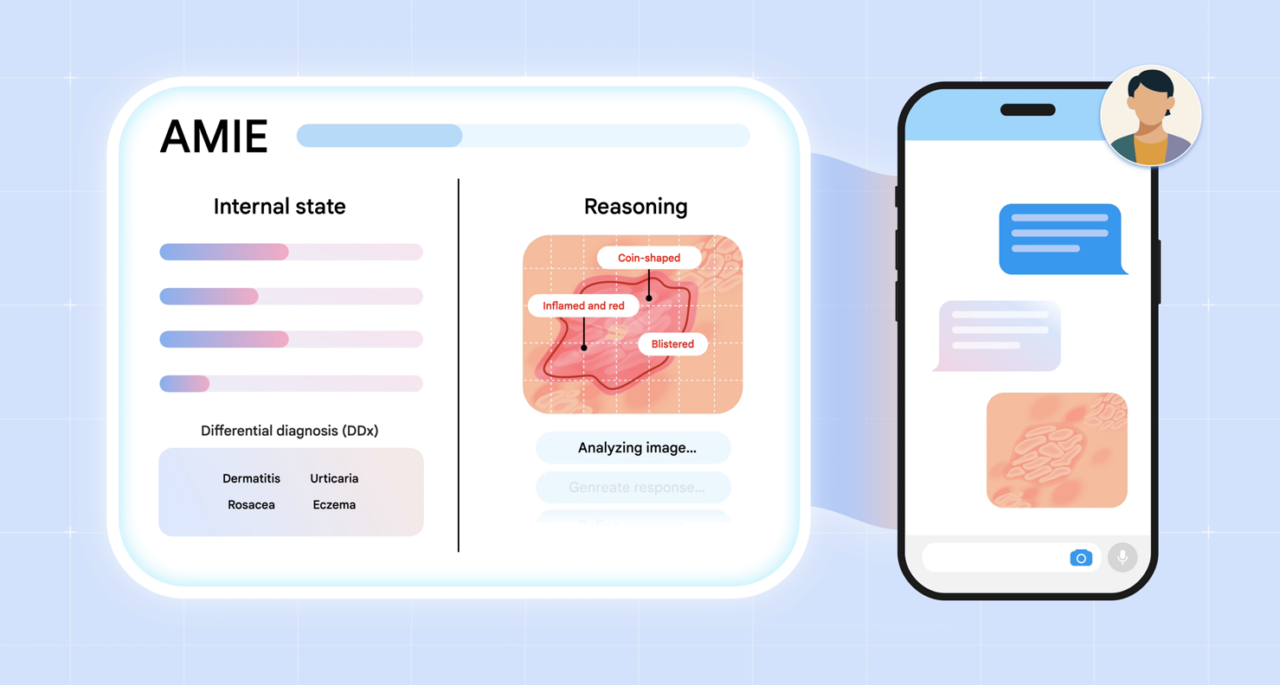

AMIE, Googles Forschungs-KI für medizinische Gespräche, macht den nächsten Schritt: Sie kann nun visuelle Informationen wie Hautbilder oder EKGs in Diagnosedialoge integrieren. In Kombination mit dem multimodalen Gemini 2.0 Flash Modell wurde ein System geschaffen, das die Struktur realer klinischer Anamnesen nachahmt und präzise auf Informationslücken reagiert.

In einer umfassenden Studie wurde AMIE mit echten Hausärzt:innen verglichen – über 105 multimodale Fallbeispiele wurden dafür genutzt. Das Ergebnis: AMIE übertraf Ärzt:innen in Diagnosegenauigkeit, Bildinterpretation und Empathie. Fachärztliche Bewertungen zeigten zudem, dass AMIE fundierte Behandlungspläne vorschlug und visuelle Daten korrekt interpretierte.

Ein besonderes Highlight ist das neu entwickelte, simulationsbasierte Testsystem, das AMIE mit realistischen Patientenszenarien trainiert. Durch diese strukturierte Umgebung konnte die KI gezielt lernen, wann und wie sie zusätzliche Informationen anfordern und in das laufende Gespräch integrieren soll.

Erste Tests mit dem neuen Gemini 2.5 Flash Modell zeigen weiteres Potenzial: Die Top-3-Diagnosegenauigkeit stieg signifikant auf 65 %, während die Sicherheit (Nicht-Halluzinationen) auf einem sehr hohen Niveau blieb.

Wichtig bleibt jedoch: Die Forschung ist ein Schritt auf dem Weg zur realen Anwendung. Derzeit läuft bereits eine erste klinische Studie mit dem Beth Israel Deaconess Medical Center, um AMIE unter realen Bedingungen zu testen.

Trotz aller Fortschritte betonen die Entwickler:innen, dass echte Arzt-Patienten-Interaktionen in Echtzeit – inklusive nonverbaler Kommunikation – weiterhin unerreicht sind. Doch die Richtung ist klar: AMIE entwickelt sich Schritt für Schritt zu einem vielseitigen KI-Werkzeug für die Medizin der Zukunft.